Sumário

Introdução: A transformação da infraestrutura de data centers para atender às demandas da IA

A inteligência artificial está transformando radicalmente o cenário tecnológico global, impondo novos desafios para a infraestrutura que sustenta essas tecnologias avançadas. O Google, como um dos principais impulsionadores dessa revolução, reconhece que a base física de seus data centers não é apenas um componente de suporte, mas um elemento crítico para o avanço contínuo da IA.

“Na Google, acreditamos que a infraestrutura física — os sistemas de energia, refrigeração e mecânicos que sustentam tudo — não é apenas importante, mas crítica para a escala contínua da IA”, afirma a empresa em suas comunicações recentes. Esta declaração reflete uma mudança fundamental na forma como os gigantes da tecnologia estão abordando o design de seus data centers.

O aumento sem precedentes na demanda computacional gerada pelos modelos de IA cada vez mais complexos está forçando uma reinvenção completa da infraestrutura tradicional. Estamos testemunhando uma transição da era onde os data centers eram projetados principalmente para cargas de trabalho de computação geral, para uma nova era onde a infraestrutura deve ser otimizada especificamente para as exigências únicas dos aceleradores de IA, como GPUs e TPUs.

Neste contexto, o Google anunciou recentemente avanços significativos em três áreas fundamentais: distribuição de energia de alta tensão, refrigeração líquida em escala de gigawatt e uma nova geração de processadores TPU (Tensor Processing Units) chamada Ironwood. Estas inovações representam não apenas melhorias incrementais, mas transformações fundamentais necessárias para sustentar o futuro da computação de IA.

Assista também ao podcast gerado por IA com base neste artigo!

A nova arquitetura de distribuição de energia do Google: De 48 VDC para +/-400 VDC

A revolução da IA está impondo demandas de energia sem precedentes nos data centers modernos. Há quase uma década, o Google foi pioneiro na adoção de sistemas de distribuição de energia de 48 VDC dentro de seus racks de TI, uma mudança que trouxe ganhos significativos em eficiência energética. No entanto, a era da IA está rapidamente ultrapassando as capacidades desta arquitetura.

O Google identificou duas tendências críticas que exigem uma transformação na distribuição de energia: a necessidade de racks capazes de suportar mais de 500 kW antes de 2030 e a crescente densificação dos racks com “xPUs” (termo que engloba GPUs, TPUs e CPUs). Estes processadores especializados para IA consomem significativamente mais energia que os servidores tradicionais, criando uma pressão sem precedentes na infraestrutura elétrica.

A solução proposta pelo Google é revolucionária: uma transição para sistemas de entrega de energia de +/-400 VDC, capazes de suportar até 1 MW por rack – um aumento dramático em relação aos sistemas atuais. Esta mudança não é apenas uma resposta reativa às necessidades imediatas, mas uma preparação estratégica para as demandas futuras da computação de IA.

A escolha da tensão nominal de 400 VDC não foi arbitrária. O Google está estrategicamente aproveitando a cadeia de suprimentos já estabelecida pela indústria de veículos elétricos (EVs), que utiliza componentes semelhantes. Esta abordagem visa capitalizar economias de escala, melhorar a eficiência de fabricação e garantir maior qualidade dos componentes.

Um aspecto notável desta transformação é o desenvolvimento de um rack de energia lateral AC-para-DC (sidecar) que desagrega os componentes de energia do rack de TI principal. Esta arquitetura inovadora não apenas melhora a eficiência energética ponta a ponta em aproximadamente 3%, mas também libera espaço valioso no rack para acomodar mais processadores de IA.

O Google não está empreendendo esta jornada sozinho. Como parte do projeto Mt Diablo, a empresa está colaborando com Meta e Microsoft no Open Compute Project (OCP) para padronizar as interfaces elétricas e mecânicas desta nova arquitetura. “O rascunho da especificação 0.5 estará disponível para feedback da indústria em maio”, informa o Google, sinalizando um compromisso com a colaboração aberta e a padronização industrial.

Esta transformação na distribuição de energia representa um dos pilares fundamentais que permitirão a próxima geração de data centers otimizados para IA, estabelecendo as bases para um futuro onde a computação de alta densidade energética se tornará a norma, não a exceção.

Refrigeração líquida: A solução essencial para o gerenciamento térmico de alta densidade

À medida que os processadores de IA evoluem em capacidade, seu consumo de energia também aumenta dramaticamente – de 100W por chip há alguns anos para mais de 1000W atualmente. Este aumento exponencial de potência gera um desafio proporcional: como dissipar eficientemente o calor gerado por estes componentes cada vez mais poderosos?

A refrigeração a ar, método tradicional utilizado em data centers por décadas, está rapidamente atingindo seus limites físicos. Neste cenário, a refrigeração líquida emerge não apenas como uma alternativa, mas como uma necessidade imperativa para o futuro dos data centers de IA.

As propriedades físicas da água tornam-na um meio de refrigeração extraordinariamente eficiente. Conforme destacado pelo Google, “a água pode transportar aproximadamente 4000 vezes mais calor por unidade de volume do que o ar para uma dada mudança de temperatura, enquanto a condutividade térmica da água é aproximadamente 30 vezes maior do que a do ar.” Estes números impressionantes explicam por que a refrigeração líquida se tornou o caminho inevitável para o gerenciamento térmico de alta densidade.

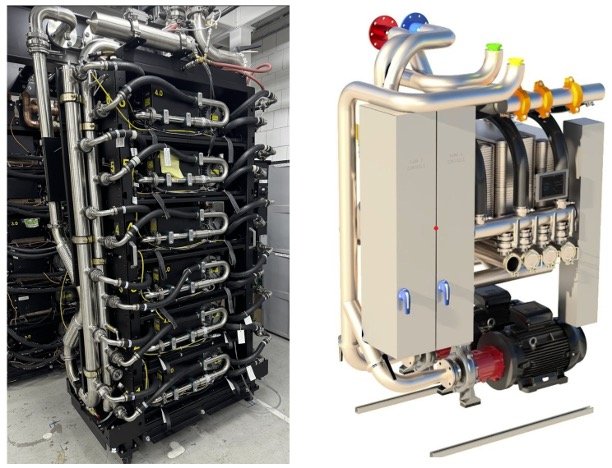

O Google não é novato nesta tecnologia. A empresa acumula uma década de experiência com refrigeração líquida, implementada em escala de Gigawatt em mais de 2000 TPU Pods nos últimos sete anos. O mais notável é a confiabilidade alcançada: “consistentemente em cerca de 99.999% de disponibilidade”, um número que rivaliza ou supera muitos sistemas de refrigeração a ar tradicionais.

Os benefícios da refrigeração líquida vão além da eficiência térmica. Esta tecnologia permite dobrar a densidade de chips e quadruplicar o tamanho dos supercomputadores em comparação com as gerações refrigeradas a ar. Isso é possível porque os volumosos dissipadores de calor a ar são substituídos por placas frias compactas, liberando espaço valioso dentro dos racks para mais componentes computacionais.

A arquitetura de refrigeração líquida do Google é sofisticada e robusta. Ela utiliza Unidades de Distribuição de Líquido (CDUs) equipadas com componentes redundantes e sistemas de alimentação ininterrupta (UPS) para garantir alta disponibilidade. Estas CDUs desempenham um papel crucial ao isolar o circuito líquido do rack do circuito da instalação, criando uma camada adicional de proteção e facilitando a manutenção.

Em um movimento significativo para o avanço da indústria como um todo, o Google anunciou que contribuirá com seu CDU de quinta geração, denominado Project Deschutes, para o Open Compute Project (OCP) ainda este ano. Esta contribuição visa acelerar a adoção da refrigeração líquida em toda a indústria, compartilhando aprendizados valiosos sobre design, qualidade, confiabilidade, implantação, serviço e desenvolvimento do ecossistema de suprimentos.

A transição para a refrigeração líquida representa uma mudança paradigmática na infraestrutura de data centers, tão fundamental quanto a própria evolução dos processadores que ela resfria. Para o Google e outros líderes da indústria, não se trata mais de uma questão de “se”, mas de “como” implementar esta tecnologia em escala global para sustentar o futuro da computação de IA.

TPU Ironwood: O processador de sétima geração para a “era da inferência”

Enquanto a infraestrutura física evolui para atender às demandas crescentes da IA, o Google também está avançando no desenvolvimento de hardware especializado para processamento de inteligência artificial. Recentemente, a empresa apresentou o Ironwood, sua TPU (Tensor Processing Unit) de sétima geração, marcando um salto significativo em capacidade e eficiência para cargas de trabalho de IA.

O Ironwood representa uma mudança estratégica no foco do Google, sendo “o primeiro TPU projetado especificamente para inferência”. Esta especialização reflete o reconhecimento de que estamos entrando na chamada “era da inferência”, onde os modelos de IA estão evoluindo de sistemas que apenas fornecem informações reativas para plataformas capazes de gerar insights e interpretações proativas.

As especificações do Ironwood são impressionantes por qualquer métrica. Quando escalado para sua configuração máxima de 9.216 chips por pod, o sistema oferece um poder computacional de 42,5 Exaflops – mais de 24 vezes superior ao do El Capitan, atualmente considerado o maior supercomputador do mundo, que oferece 1,7 Exaflops por pod. Esta capacidade computacional massiva é essencial para executar os modelos de linguagem de grande escala (LLMs) e os modelos de mistura de especialistas (MoEs) que estão na vanguarda da pesquisa em IA.

Os ganhos em eficiência energética são igualmente notáveis. O Ironwood oferece o dobro do desempenho por watt em comparação com o Trillium, a TPU de sexta geração anunciada no ano passado. Em uma perspectiva mais ampla, é quase 30 vezes mais eficiente em termos de energia do que o primeiro Cloud TPU v2 lançado em 2018. Esta evolução na eficiência energética é crucial não apenas para reduzir custos operacionais, mas também para minimizar o impacto ambiental dos data centers de IA.

Um dos avanços mais significativos do Ironwood está na capacidade e velocidade de memória. Cada chip conta com 192 GB de memória de alta largura de banda (HBM), seis vezes mais que seu predecessor. Esta expansão massiva na capacidade de memória permite processar modelos e conjuntos de dados substancialmente maiores, um requisito fundamental para os LLMs contemporâneos que podem conter centenas de bilhões ou até trilhões de parâmetros.

A largura de banda de memória também recebeu um impulso dramático, atingindo 7,37 TB/s por chip – 4,5 vezes superior à do Trillium. Paralelamente, a largura de banda de interconexão entre chips (ICI) foi aprimorada para 1,2 TBps bidirecional, um aumento de 50% em relação à geração anterior. Estas melhorias são cruciais para cargas de trabalho intensivas em memória e para facilitar a comunicação rápida entre chips em cenários de treinamento e inferência distribuídos em larga escala.

Uma inovação particularmente notável no Ironwood é o SparseCore aprimorado, um acelerador especializado para processar embeddings ultra-grandes. Este componente é otimizado para lidar com as representações vetoriais esparsas que são fundamentais para muitas aplicações modernas de IA, como sistemas de recomendação e processamento de linguagem natural.

No aspecto de software, o Ironwood utiliza o sistema Pathways do Google, uma plataforma de computação distribuída projetada para orquestrar eficientemente o processamento em múltiplos chips TPU. Esta integração entre hardware e software representa a abordagem holística do Google para a computação de IA, onde cada componente é otimizado para trabalhar em harmonia com os demais.

O lançamento do TPU Ironwood posiciona o Google na vanguarda da computação de inferência de IA, oferecendo aos clientes do Google Cloud a capacidade de executar as cargas de trabalho de IA mais exigentes com desempenho superior e maior eficiência de custo e energia. Esta evolução no hardware especializado, combinada com as inovações na infraestrutura física discutidas anteriormente, forma a espinha dorsal tecnológica que sustentará a próxima geração de aplicações de IA.

Colaboração e padrões abertos: O papel do Google no Open Compute Project (OCP)

Em meio à corrida tecnológica pela supremacia em infraestrutura de IA, o Google tem adotado uma abordagem que pode parecer contraintuitiva à primeira vista: compartilhar suas inovações com a indústria. Esta estratégia se materializa principalmente através de sua participação ativa no Open Compute Project (OCP), uma iniciativa colaborativa que visa redesenhar a tecnologia de hardware para torná-la mais eficiente, flexível e escalável.

A parceria de longa data do Google com o OCP não é apenas um gesto de boa vontade, mas um reconhecimento pragmático de que os desafios impostos pela era da IA são grandes demais para serem enfrentados isoladamente. A padronização e a colaboração aberta são essenciais para acelerar a inovação e garantir a interoperabilidade em um ecossistema tecnológico cada vez mais complexo.

Dois projetos recentes exemplificam o compromisso do Google com esta abordagem colaborativa: o projeto Mt Diablo e o Project Deschutes. O primeiro, focado na padronização da arquitetura de energia +/-400 VDC, representa uma colaboração direta com concorrentes como Meta e Microsoft para estabelecer interfaces elétricas e mecânicas comuns. “O rascunho da especificação 0.5 estará disponível para feedback da indústria em maio”, informa o Google, sinalizando um processo transparente e inclusivo.

Paralelamente, a contribuição do CDU de quinta geração (Project Deschutes) para o OCP demonstra o compromisso do Google em compartilhar não apenas especificações técnicas, mas também aprendizados valiosos acumulados ao longo de uma década de experiência com refrigeração líquida. Estes aprendizados abrangem aspectos críticos como design, qualidade, confiabilidade, implantação, serviço e desenvolvimento do ecossistema de suprimentos.

Os benefícios desta abordagem colaborativa são múltiplos e significativos. Para o Google, a padronização ajuda a criar economias de escala, reduzindo custos e acelerando a adoção de novas tecnologias. Para a indústria como um todo, estas contribuições permitem que empresas de todos os tamanhos acessem designs avançados sem precisar reinventar a roda, democratizando o acesso à infraestrutura de ponta.

Além disso, a padronização reduz a fragmentação do mercado, facilitando a interoperabilidade entre diferentes sistemas e componentes. Isto é particularmente importante em um cenário onde a complexidade tecnológica está aumentando exponencialmente, e onde a integração de diversos subsistemas é um desafio constante.

A abordagem do Google ao OCP também reflete uma visão de longo prazo sobre sustentabilidade e responsabilidade ambiental. Ao compartilhar designs que priorizam a eficiência energética e a otimização de recursos, a empresa contribui para reduzir o impacto ambiental coletivo da indústria de data centers, que é conhecida por seu consumo intensivo de energia.

Esta filosofia de colaboração aberta contrasta com abordagens mais proprietárias e fechadas, demonstrando que mesmo em um ambiente altamente competitivo, há espaço e necessidade para cooperação em áreas fundamentais de infraestrutura. O Google parece reconhecer que o avanço da IA como um todo depende de uma base tecnológica robusta e acessível, e que contribuir para esta base beneficia não apenas competidores individuais, mas o ecossistema tecnológico global.

Conclusão: Implicações para o futuro dos data centers na era da IA

As inovações apresentadas pelo Google em sua infraestrutura de data center e processadores especializados sinalizam uma transformação fundamental na arquitetura tecnológica para a era da IA. A transição para sistemas de distribuição de energia de +/-400 VDC, a adoção da refrigeração líquida em escala de gigawatt e o desenvolvimento do TPU Ironwood estabelecem novos parâmetros que redefinirão o design de data centers nas próximas décadas, tornando-se imperativos tecnológicos para qualquer organização que pretenda competir seriamente no campo da IA avançada.

A abordagem colaborativa do Google, manifestada através de suas contribuições ao Open Compute Project, reconhece que os desafios impostos pela IA são grandes demais para serem enfrentados isoladamente. Esta estratégia de inovação aberta, combinada com os impressionantes ganhos em eficiência energética, não apenas acelera a adoção de tecnologias avançadas em toda a indústria, mas também contribui significativamente para mitigar o impacto ambiental da computação de IA em escala crescente.

Para profissionais de TI, fornecedores de equipamentos e empresas que dependem de serviços de nuvem, estas mudanças implicam em uma necessidade urgente de adaptação a novas arquiteturas e competências técnicas. À medida que a indústria abraça estes novos paradigmas, a colaboração, padronização e sustentabilidade emergem como princípios fundamentais que guiarão o desenvolvimento de data centers capazes de suportar as demandas cada vez mais ambiciosas da inteligência artificial, transformando fundamentalmente como interagimos com a tecnologia.